CES2019 - 지금까지 이런 전시회는 없었다. 가전 전시회인가 AI 전시회인가

by Jeongjin Kim

CES 2019 이름만 들어도 설레는 세계 최대의 가전 전시회를 참관했다. 지구 반대편에 있는 머나먼 나라에서 전 세계 최고의 기업들이 서로의 기술을 뽐내는 모습은 누구라도 흥분하게 만들기 충분했다.

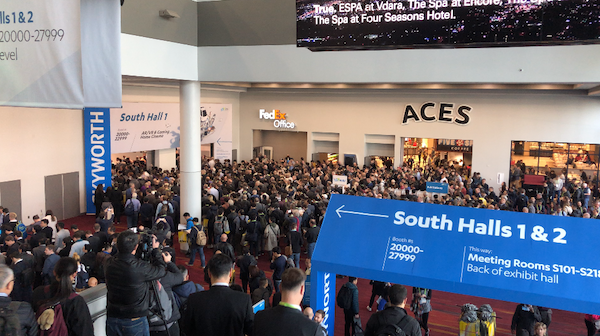

2019년 1월 6일부터 9일까지 개최된 CES 2019는 4,500여 개 기업과 18만 명 이상 참석자가 몰린 그야말로 어마어마한 규모의 전시회였다.

3일 동안 쉬지 않고 둘러보았으나 반도 못 볼 정도였을 뿐만 아니라 삼성, LG 같은 인기 있는 전시 부스는 몸을 제대로 움직일 수 없을 정도였다.

CES에 전시된 수많은 제품을 보면서 가장 많이 본 단어는 다름 아닌 AI 였다. 대기업이건 스타트업이건 제품 대부분에 AI를 핵심 재료로 사용하고 있었다.

Why now?

인공지능은 지난 수십 년간 컴퓨터 사이언스 분야에서 그저 연구만 해왔던 기술이었는데 최근 3~4년 들어 AI에 대한 관심과 투자가 집중되기 시작했다. 왜일까?

카카오 AI 리포트에 따르면 그 이유를 세 가지로 요약하고 있다.

- Connected everything

- Computing power

- Data

IoT 기술과 스마트폰을 필두로 수많은 기기가 서로 연결되어 무궁무진한 데이터들을 만들어 내고 있고, 충분히 성숙한 클라우드 서비스를 통해 합리적인 가격과 방식으로 사용할 수 있는 컴퓨팅 파워가 데이터를 분석할 수 있는 환경을 만들었기 때문이라고 설명하고 있다.

여기서 AI가 더 폭발적으로 성장하게 된 이유를 하나 더 추가하자면 사용자 인터페이스라고 생각한다.

Amazon alexa와 Google assistant는 그동안 수많은 데이터를 분석한 결과를 가지고 있는 AI 시스템과 인간을 연결해주는 매우 중요한 역할을 했다. 사용자의 접근이 편리해짐에 따라 사용자 요구사항이 늘어나고 이를 만족시키기 위한 기업들이 노력이 AI 대중화를 가속화했다.

CES의 구글 전시관은 구글 어시스턴스를 지원하는 제품들을 전시해서 인산인해를 이루었다. 커피머신, 콘센트, 도어락 등 이런 것까지? 라는 생각이 들 정도로 정말 다양한 제품들이 전시되어 있었다. 사실 이곳에 전시된 제품뿐만 아니라 IoT 관련 제품들은 Amazon alexa 나 Google assistant 둘 중에 적어도 하나는 지원하여서 전시장 전체가 두 업체의 전시장이라고 해도 과언이 아니었다.

가까운 미래에는 센서를 이용해 실제 세계와 상호작용하는 모든 디바이스에 AI 기능이 추가될 것이고 알렉사와 같이 음성 기반 인터페이스를 통해 제어될 것이라고 쉽게 예측해볼 수 있었다. 또 카메라가 달린 모든 기기는 사물을 구분하고 사람의 얼굴을 인식할 수 있게 하는 기능을 가지게 될 것이다.

CES 스타트업 전시관에는 이 카메라를 이용해서 사물을 인식하는 기술을 활용한 다양한 제품이 전시되어 있었다. 스마트 조명, 건강관리 로봇, 스마트 도어벨 등 우리 생활에 밀접하게 연관된 제품이 많았는데 그중에서 Litmor capsule이라는 최초로 AI를 탑재한 옥외등이 눈에 띄었다. 기존에 설치된 조명을 대체 설치하기만 하면 돼서 설치하기도 편리하고 사람, 사물 특히 일상적인 움직임과 아닌 것을 구분해서 연계된 곳으로 알람을 주는 기능은 상당히 매력적이었다.

소외된 계층

인공지능은 미디어, 광고, 금융, 유통 산업에 가장 많이 이용되고 있다. 누구나 아는 유튜브는 사용자가 영상 몇 개만 보면 이상하게 또 클릭하고 싶은 추천 동영상을 계속 보여준다. 아무 생각 없이 클릭하다 보면 밤새는 건 일도 아니게 된다. 그러다가 블로그에 글을 좀 보려고 클릭하면 이상하게 또 사려고 했던 물건이 광고에 딱 나온다.

이렇게 온라인으로 무언가 하는 산업에서는 인공지능이 어마어마한 역할을 하고 있다는 것은 누구라도 부정할 수 없는 사실일 것이다. 그런데 인공지능에 소외되고 있었던 제품 또는 산업이 있다.

바로 오프라인 제품들이다.

이게 당연히 그럴 만도 한 것이 AI와 항상 같이 붙어 다니는 친구 빅데이터가 있는데 이걸 분석하려면 클라우드 아니고서는 어지간한 로컬 환경에서는 답이 없다. 오프라인이니까 분석한 결과를 받을 수 없다.

그래서 AI 쪽에서는 이제 오프라인 제품에도 머리를 달아보자 하는 트렌드가 나타나고 있다.

오프라인 제품에 머리를 달려면 배우는 방법부터 바꾸자

인터넷과 떨어진 세계의 제품들이 무언가 배워서 똑똑해지기 위해 필요한 조건이 있다.

- 첫 번째, 적은 데이터로도 충분히 똑똑해져야 한다.

스마트 시계를 예를 들어 보겠다.

만약 스마트 시계가 오프라인 제품인데 골프 스윙하는 것을 인식해서 사용자에게 딱 맞는 클럽을 찾아 주는 피팅 기능이 있다고 가정해 보자.

그런데 그 기능을 쓰기 위해 100만 번 정도의 스윙 패턴을 학습해야 한다면 골프 클럽 하나 사려다가 사람이 먼저 죽을 수도 있다. 그래서 몇 번 안 되는 적은 데이터로도 충분히 그 특징을 잡아서 활용해야 한다는 의미이다.

- 두 번째, 제품이 수명을 다할 때까지 배워야 한다.

사람은 환경이 바뀌면 그에 맞게 스스로 배운다. 그러나 인공지능은 배우지 않은 것은 모른다. 만약 주변 환경이 바뀌어서 행동해야 할 조건들이 바뀌면 그 제품은 아무런 혜택도 사용자에게 주지 못한다. 온라인이면 실시간으로 업데이트라도 할 수 있는 기회가 있는데 그렇지 않다면 스스로 계속해서 배워야 한다.

- 세 번째, 혼자서 배워야 한다.

지금까지 머신러닝은 클라우드 상에서 이루어지고 있고 그 결과만 사용자 기기로 전송하는 방식이었다. 하지만 단말기에서 직접 학습을 하게 되면 조금 더 개인화된 서비스를 받을 수 있고 서버에 데이터를 전송하지 않으므로 보안에도 유리하다.

그런데도 지금껏 하지 못한 것은 AI를 위한 데이터를 분석하기에는 많은 처리 비용이 들기 때문이다. 그래서 nVidia, AMD, Qualcomm 같은 반도체 회사들은 머신러닝에 특화된 칩을 개발해서 판매하고 있는데 GPU처럼 AI를 위한 칩셋을 PC나 스마트폰에 기본적으로 장착하는 시대가 곧 올 것으로 생각한다.

아래는 Google과 NXP에서 만든 AI 전용 칩셋을 장착한 데모 장비를 시연하는 영상이다.

첫 번째 시연은 완전히 오프라인 상태에서 물체를 학습하여 분류하는 기술이다.

두 번째 시연은 현재 카메라가 보고 있는 물체를 실시간으로 분석하여 그 결과를 클라우드 상에 전송하면 어떤 물체인지 알려주는 기술이다. 이것은 온라인상의 제품들이 분석할 것을 클라우드에 주는 것이 아니라 분석한 것을 클라우드에 주는 방법으로 학습의 분산화(?) 탈중앙화(?)를 할 수 있음을 볼 수 있다.

소프트웨어에서 Edge-AI를 구현하기 위한 노력도 있었는데, ANAGOG이라는 업체는 스마트 폰에서 별다른 AI 전용 칩셋이 없더라도 충분한 성능을 내는 머신러닝 엔진(JedAI)을 내놓기도 했다.

AI 가 사람을 도와주느냐, 사람이 AI를 도와주느냐

요즘 온라인 음악 스트리밍 서비스를 사용하면서 내가 듣고 싶은 음악을 일일이 재생목록에 넣고 들어 본 적이 없는 것 같다. 그냥 “신날 때”, “일할 때”, “내가 좋아하는 음악” 이런 버튼을 누르기만 하면 어쩜 그리 내 맘에 쏙 드는 음악을 골라서 틀어주는지 신기할 정도이다. 딱 십 년 전에 매일 나를 위해 선곡을 해줬으면 좋겠다고 생각했었는데 벌써 이렇게 자연스러운 일이 되어 버렸다.

AI 기술은 정말 하루가 다르게 발전하고 있다. 수년 전부터 우리 생활 속에 하나둘씩 자리 잡기 시작해서 지금은 AI 없이는 일상생활이 힘들 정도가 되었다. 머지않아 AI 가 일을 하는데 옆에서 단순한 작업만 거들어 주는 업무 형태가 오지 않을까 걱정이 된다. 그럼 더 좋으려나?

참고 자료

- CES 2019 LG Keynote

- 카카오 AI 리포트 / 북바이북

- 백설공주 거울과 인공지능 이야기 / 제이펍

- CES Daily article / https://www.twice.com/industry/ces-2019-how-smart-will-ai-get

- 13 major Artificial Intelligence trends to watch for in 2018 / https://www.geospatialworld.net/blogs/13-artificial-intelligence-trends-2018/

Subscribe via RSS